Optimización KDE – Validación cruzada imparcial

Ahora, expandamos el término cuadrático:

A continuación, reorganizar los términos:

- $\hat{f}(x;h)$ es el estimador KDE de la función de densidad de probabilidad en $x$.

- $f(x)$ es la función de densidad de probabilidad de la distribución de población subyacente.

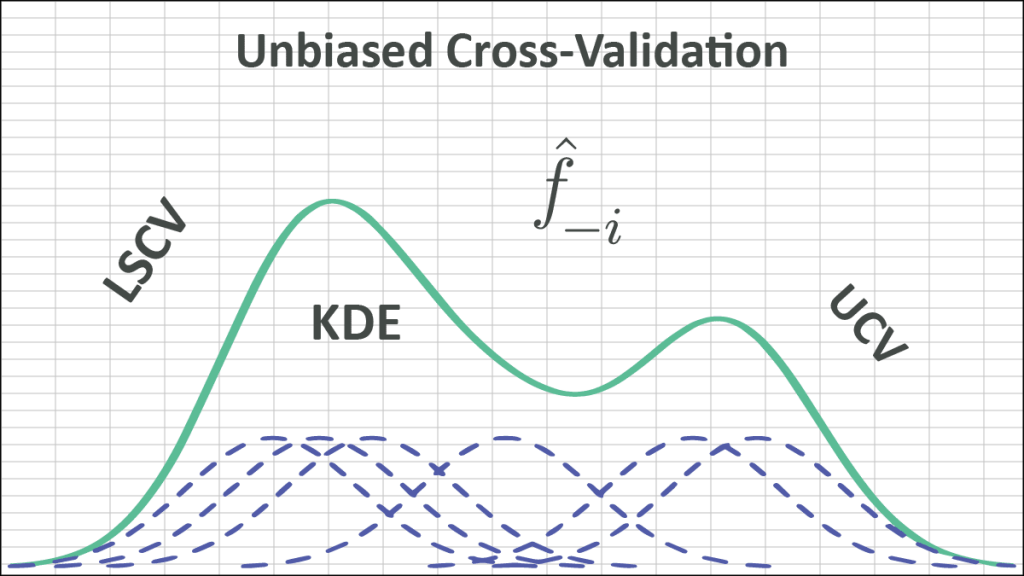

En este artículo, vamos un paso más allá y abordamos el método de optimización de validación cruzada imparcial para KDE.

Para nuestros propósitos de optimización del ancho de banda, el término $\int f {(x)^2}dx$ aunque se desconoce, es constante (es decir, independiente del ancho de banda h del kernel). Minimizar MISE es equivalente a minimizar la validación cruzada de mínimos cuadrados (LSCV):

Esta cantidad es desconocida, pero se puede estimar sin sesgo de la siguiente manera:

- Primero, estimemos el segundo término (ej., $\mathbb{E}\left[ \int{{\hat{f}}}(x;h)f(x)dx \right]$):

$$\mathbb{E}\left[ \int{{\hat{f}}}(x;h)f(x)dx \right]=\frac{1}{n}\sum\limits_{i=1}^{n}{{{{\hat{f}}}_{-i}}({{X}_{i}};h)}$$

Donde:

- ${{\hat{f}}_{-i}}({{X}_{i}};h)$ es el dejar uno fuera de (ej., punto de dato ith) KDE. $${{\hat{f}}_{-i}}(X;h)=\frac{1}{n-1}\sum\limits_{j=1,j\ne i}^{n}{{{K}_{h}}}(X-{{X}_{j}})=\frac{1}{(n-1)h}\sum\limits_{j=1,j\ne i}^{n}{K}\left( \frac{X-{{X}_{j}}}{h} \right)$$

Entonces,

$$\mathbb{E}\left[ \int{{\hat{f}}}(x;h)f(x)dx \right]=\frac{1}{n(n-1)h}\sum\limits_{i=1}^{n}{\sum\limits_{j=1,i\ne j}^{n}{K\left( \frac{{{X}_{i}}-{{X}_{j}}}{h} \right)}}$$Como la función de kernel function es simétrica (ej., (i.e., $K(-x)=K(x)$), podemos simplificar aún más el término:

$$\mathbb{E}\left[ \int{{\hat{f}}}(x;h)f(x)dx \right]=\frac{2}{n(n-1)h}\sum\limits_{i=1}^{n-1}{\sum\limits_{j=i+1}^{n}{K\left( \frac{{{X}_{i}}-{{X}_{j}}}{h} \right)}}$$ - Luego estimemos el primer término (ej., $\mathbb{E}\left[ \int{{\hat{f}}}{{(x;h)}^{2}}dx \right]$):

$$\hat{f}(x;h)=\frac{1}{nh}\sum\limits_{i=1}^{n}{K((x-{{X}_{i}})/h)}$$

$$\hat{f}{{(x;h)}^{2}}=\frac{1}{{{(nh)}^{2}}}\left( \sum\limits_{i=1}^{n}{{{K}^{2}}((x-{{X}_{i}})/h)+2\sum\limits_{i=1}^{n-1}{\sum\limits_{j=i+1}^{n}{K((x-{{X}_{i}})/h)\times K((x-{{X}_{j}})/h)}}} \right)$$

Ahora trae la integral en:

$$\int{\hat{f}{{(x;h)}^{2}}dx}=\frac{1}{{{(nh)}^{2}}}\left( \sum\limits_{i=1}^{n}{\int{{{K}^{2}}((x-{{X}_{i}})/h)dx}+2\sum\limits_{i=1}^{n-1}{\sum\limits_{j=i+1}^{n}{\int{K((x-{{X}_{i}})/h)\times K((x-{{X}_{j}})/h)dx}}}} \right)$$Pero dejemos: $z=(x-{{X}_{i}})/h$:

$$\int{{{K}^{2}}((x-{{X}_{i}})/h)dx}=h\int{{{K}^{2}}(z)dz}=h\times R(K)$$ $$\int{K((x-{{X}_{i}})/h)\times K((x-{{X}_{j}})/h)dx}=h\int{K(z)\times K(z+({{X}_{i}}-{{X}_{j}})/h)dz}$$Y $K(.)$ es la función simétrica:

$$\int{K((x-{{X}_{i}})/h)\times K((x-{{X}_{j}})/h)dx}=h\int{K(z)\times K(({{X}_{j}}-{{X}_{i}})/h-z)dz=h\times {{K}^{\otimes }}(}({{X}_{j}}-{{X}_{i}})/h)$$Donde ${{K}^{\otimes }}(.)$es la función de autoconvolución del núcleo:

$$\int{\hat{f}{{(x;h)}^{2}}dx}=\frac{R(K)}{nh}+\frac{2}{{{n}^{2}}h}\sum\limits_{i=1}^{n-1}{\sum\limits_{j=i+1}^{n}{{{K}^{\otimes }}(({{X}_{j}}-{{X}_{i}})/h)}}$$Poniendo términos juntos en la fórmula MISE, obtenemos:

$$\text{LSCV}(h)=\mathbb{E}\left[ \int{{\hat{f}}}{{(x;h)}^{2}}dx \right]-2\mathbb{E}\left[ \int{{\hat{f}}}(x;h)f(x)dx \right]$$ $$\text{LSCV}(h)=\frac{1}{nh}\left[ R(K)+\frac{2}{n}\sum\limits_{i=1}^{n-1}{\sum\limits_{j=i+1}^{n}{{{K}^{\otimes }}(({{X}_{j}}-{{X}_{i}})/h)}}-\frac{4}{(n-1)}\sum\limits_{i=1}^{n-1}{\sum\limits_{j=i+1}^{n}{K(({{X}_{i}}-{{X}_{j}})/h)}} \right]$$Finalmente, buscamos (numéricamente) un ancho de banda óptimo que minimice la función LSCV anterior.

Para acelerar la convergencia de la solución de optimización, los métodos numéricos a menudo requieren la primera y la segunda derivada de la función de utilidad:

$$\begin{align} & \frac{\partial }{\partial h}\text{LSCV}(h)=-\frac{\text{LSCV}(h)}{h}- \\ & \frac{1}{n{{h}^{3}}}\left[ \frac{2}{n}\sum\limits_{i=1}^{n-1}{\sum\limits_{j=i+1}^{n}{({{X}_{j}}-{{X}_{i}}){{K}^{\otimes (1)}}(({{X}_{j}}-{{X}_{i}})/h)}}-\frac{4}{(n-1)}\sum\limits_{i=1}^{n-1}{\sum\limits_{j=i+1}^{n}{({{X}_{j}}-{{X}_{i}}){{K}^{(1)}}(({{X}_{i}}-{{X}_{j}})/h)}} \right] \\ \end{align} $$Y la segunda función derivada, de la siguiente manera:

\begin{align} & \frac{{{\partial }^{2}}}{\partial {{h}^{2}}}\text{LSCV}(h)=-\frac{1}{h}\times \frac{\partial }{\partial h}\text{LSCV(h)+}\frac{\text{LSCV(h)}}{{{h}^{2}}}+ \\ & \frac{3}{n{{h}^{4}}}\left[ \frac{2}{n}\sum\limits_{i=1}^{n-1}{\sum\limits_{j=i+1}^{n}{({{X}_{j}}-{{X}_{i}}){{K}^{\otimes (1)}}(({{X}_{j}}-{{X}_{i}})/h)}}-\frac{4}{(n-1)}\sum\limits_{i=1}^{n-1}{\sum\limits_{j=i+1}^{n}{({{X}_{j}}-{{X}_{i}}){{K}^{(1)}}(({{X}_{i}}-{{X}_{j}})/h)}} \right]+ \\ & \frac{1}{n{{h}^{5}}}\left[ \frac{2}{n}\sum\limits_{i=1}^{n-1}{\sum\limits_{j=i+1}^{n}{{{({{X}_{j}}-{{X}_{i}})}^{2}}{{K}^{\otimes (2)}}(({{X}_{j}}-{{X}_{i}})/h)}}-\frac{4}{(n-1)}\sum\limits_{i=1}^{n-1}{\sum\limits_{j=i+1}^{n}{{{({{X}_{j}}-{{X}_{i}})}^{2}}{{K}^{(2)}}(({{X}_{i}}-{{X}_{j}})/h)}} \right] \\ \end{align}

La optimización numérica de la función LSCV puede ser un desafío. En la práctica, son posibles varios mínimos locales, y la rugosidad de la función objetivo puede variar notablemente dependiendo de $n$ y $f$. En consecuencia, las rutinas de optimización pueden quedar atrapadas en soluciones espurias.

La presencia de múltiples mínimos presenta un desafío para los optimizadores numéricos, pero puede solucionarse seleccionando el mayor valor de h para el cual se presenta el mínimo local.

Discusión

A diferencia de la regla empírica de Silverman y los métodos de complemento directo de Sheather & Jones, la UCV no hace ninguna suposición sobre la verdadera función de distribución (por ejemplo, que es intuitiva y asintóticamente óptima en condiciones muy débiles).

No obstante, la tasa relativa de convergencia de LSCV(h) a h o \hat{h} está en el orden de la décima raíz del tamaño de la muestra O\left(n^{-1/10}\right)), que es extremadamente lento, pero la mejor tarifa para.

Además, LSCV sufre mucho con las variaciones de muestra (es decir, diferentes muestras de la misma distribución de valores de ancho de banda estimados tienen una gran variación).

Finalmente, el LSCV a menudo tiene varios mínimos (espurios), pero se puede remediar fácilmente seleccionando el valor más grande. En algunas ocasiones, los mínimos locales pueden no estar presentes en absoluto.

Referencias

- Silverman, B.W. (1986). Density Estimation for Statistics and Data Analysis. Chapman & Hall/CRC London.

- W. Zucchini, Applied smoothing techniques, Part 1 Kernel Density Estimation., 2003.

- Byeong U. Park and J. S. Marron. Comparison of Data-Driven Bandwidth Selectors. Journal of the American Statistical Association Vol. 85, No. 409 (Mar., 1990), pp. 66-72 (7 pages).

- S.J. Sheather and M.C. Jones. A reliable data-based bandwidth selection method for kernel density estimation. J. Royal Statist. Soc. B, 53:683-690, 1991.

- Bowman, A., An alternative method of cross-validation for the smoothing of density estimates, Biometrika, 71 (1984) 353-360.

- Rudemo, M., Empirical choice of histograms and kernel density estimators, Scandinavian Journal of Statistics, 9 (1982) P 65-78.